L’intelligence artificielle nous tend sa main verte pour adresser le plus grand défi de l’homme du 21ème siècle : la restauration et la sauvegarde de notre planète.

Nous verrons dans cette article, pourquoi et comment l’IA apporte des solutions concrètes dans de nombreux domaines concernés par l’intelligence artificielle et l’environnement : les pollutions des sols, de l’air et des océans, l’épuisement des ressources, la disparition des espèces, les transitions énergétiques, la mobilité durable, la surconsommation et le gaspillage…

Table des matières

Connaissez-vous la vraie obésité de l’homme ?

Le poids de tout ce que l'Homme a fabriqué dépasse désormais celui de tous les êtres vivants sur Terre (Biomasse), soit 30.000 milliards de tonne

Source : « The Anthropocene Review » (décembre 2020) Tweet

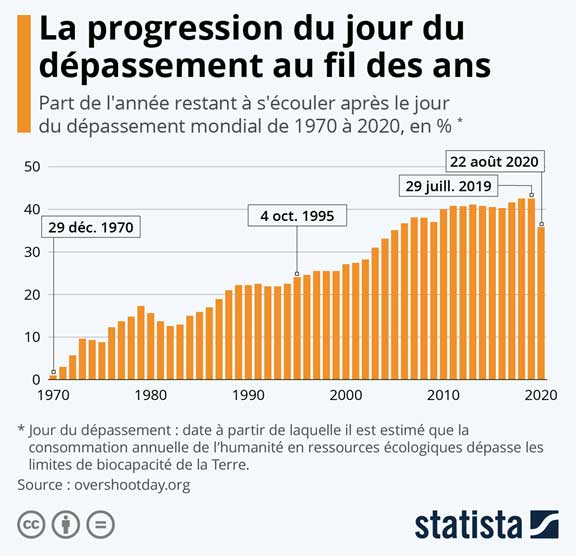

Et cette surproduction et la surexploitation des ressources naturelles associée affectent directement notre empreinte écologique. En effet, les ressources que nous exploitons auprès de notre planète ne sont pas illimitées. De fait, cepuis les années 1970, nous épuisons ces ressources de façon irréversible tout en produisant davantage de déchets. Dès lors, la biocapacité de la terre n’est plus en mesure de produire et surtout de reproduire des ressources naturelles pour répondre aux sollicitations de l’homme.

Le jour du dépassement :

Le 22 août 2020, l'humanité avait dépensé l'ensemble des ressources que la Terre pouvait renouveler en un an. Autrement dit, le jour du dépassement mondial nous plonge pendant 4 mois dans la zone rouge.

Source : overshootday.org Tweet

Sources : Statista, 21 août 2020

En outre, cette date est calculée par l’ONG américaine Global Footprint Network. Elle correspond au moment où l’humanité est supposée avoir consommé l’ensemble des ressources écologiques que la planète est capable de régénérer en un an (biocapacité).

De plus, l’année 2020 sera également profondément marquée par la crise sanitaire liée à la pandémie de Covid-19. Car, cette crise a plongé l’humanité tout entière dans un confinement sans fin avec de nombreux effets de bord.

D’un côté, la nature a repris ses droits, partout où l’homme s’est mis en retrait :

- En France, des daims ont été aperçus en plein jour dans les rues de Boissy-Saint-Léger (Val-de-Marne),

- En Italie, à Venise, l’eau étant devenue plus limpide, les poissons sont de retour dans les canaux de la cité des Doges,

- Dans le sud de la Sardaigne, des dauphins ont été vus nageant dans le port de Cagliari.

De l’autre, l’homme s’est réapproprié le mot résilience (dès le premier confinement). Et il a changé ses modes de communication, plus tournés vers les outils numériques, et sa consommation plus orientée locale avec des circuits courts.

(*) Source : Google trends France

En outre, sur le plan économique, la crise sanitaire a permis une forte accélération des transformations numériques déjà en marche. On parle d’un bond de 5 à 10 ans rattrapés. En l’occurrence, il s’agit de faire face à l’émergence des nouveaux prospects et clients, désormais digital-first.

Selon le rapport Tendances Digitales 2021 d’Adobe, de nouvelles priorités dans les investissement marketing sont nécessaires pour transformer la façon d’interagir avec les audiences. En effet, il faut répondre favorablement à leurs attentes et retrouver le chemin de la croissance économique.

Parmi les nombreuses possibilités et disciplines disponibles au sein du marketing digital, on distingue désormais l’intelligence artificielle. Elle se positionne non pas pour remplacer l’intelligence humaine mais pour apporter une vraie valeur ajoutée à cette dernière. L’IA procure en effet de hauts potentiels dans ce monde où les données sont devenues à la fois :

- volumineuses, véhiculées en temps réel, structurées ou non structurées (à 80% selon le rapport d’IDC Corp du 2 mars 2021);

- et à la fois le nouveau pétrole qu’il faut forer, collecter et raffiner pour alimenter son moteur de croissance.

Mais il faut pourtant prendre garde à ne pas augmenter davantage notre empreinte écologique en misant autant sur le digital. Voyez par vous-même combien la pollution numérique affecte déjà notre environnement en consommation carbone :

- la gestion de nos emails et de nos abonnements ?

- La vidéo consommée, en streaming ou en téléchargement ?

- Les requêtes sur les moteurs de recherche ?

- Les onglets inutiles sur nos navigateurs web ?

- Le stockage en ligne?

En effet, le numérique est capable d’une hausse significative de notre consommation carbone MAIS aussi une source de nombreuses opportunités pour apporter des solutions durables. Car la technologie joue déjà un rôle crucial en créant des outils de prévention et en apportant des solutions concrètes pour l’environnement ! A ce titre, l’Intelligence Artificielle durable est déjà une alliée au service de la restauration et de la sauvegarde de notre planète. Attention donc à ne pas déplacer le problème !

Qu’est-ce que l’Intelligence Artificielle Durable? Comment la développer ? Comment l’IA peut-elle avoir la main verte, contribuer à réparer les dommages et à sauver la planète ?

L’importance d’une Intelligence Artificielle Durable

Dès lors, de quoi parle-t-on et pourquoi ? IA durable, IA raisonnée, IA verte, IA éco-responsable ou encore IA frugale ? C’est autant de vocabulaire qui traduit une volonté commune d’utiliser l’intelligence artificielle (définie dans notre glossaire) pour contribuer positivement dans différents domaines tout en préservant le capital santé de notre planète !

Car au cours des 200 dernières années, une série de révolutions industrielles a radicalement amélioré notre niveau de vie. Mais chaque révolution industrielle passée a également affecté l’avenir des générations futures qui risquent d’en payer le prix fort. Donc, cette révolution-là doit se faire de façon plus intelligente, c’est le cas de le dire !

Quel potentiel pour l’intelligence artificielle et l’environnement selon-vous ?

Le recours à l’intelligence artificielle permettrait de réduire de 4% les émissions mondiales de gaz à effet de serre d'ici 2030.

Source : Etude Microsoft et PwC “How AI can enable a Sustainable Future.” Tweet

L’ère de l’information, voire de l’infobésité, est à l’origine de progrès incroyables et à une vitesse impressionnante. Et l’IA permet aux humains d’exploiter de grandes quantités de données et de faire des progrès décisifs dans tous les domaines. Notamment, pour démêler à l’échelle macro le réseau complexe de problèmes que subit la planète.

A l’échelle micro, au sein de l’entreprise, l’intelligence artificielle est capable d’apporter une contribution positive auprès de l’ensemble de la chaîne de valeur :

- pour concevoir des nouveaux produits éco-responsables ;

- calculer l’impact carbone dès l’extraction de ressources jusqu’à la distribution ;

- optimiser les flux logistiques ;

- améliorer l’efficacité énergétique des usines et entrepôts ;

- ou réduire les pertes et les déchets produits en favorisant la réutilisation et l’économie circulaire…

Oui mais, attention justement à notre consommation excessive d’énergie ! Car c’est l’une des principales causes des émissions de gaz à effet de serre ! En l’occurrence, l’IA repose sur une infrastructure numérique. Elle nécessite parfois une grande puissance de traitement en fonction du nombre d’opérations à réaliser. Et aussi en fonction des itérations de son apprentissage, pour devenir suffisamment intelligente et opérationnelle.

Dans la thèse professionnelle rédigée par Denis Lefebvre, on peut observer l’ampleur du phénomène. En effet, certaines IA, telle que IA Transformer est composée de 213 millions de paramètres. Dès lors, elle consomme lors d’une session d’entrainement, l’équivalent de 57 fois la consommation carbone d’une seule famille en mode de vie standard pendant 1 an.

De son côté, GoogleBrain, l’IA de Google destinée à la traduction, NLP pour Natural Language Processing (traitement automatique du langage naturel), n’est pas en reste. Car elle compte désormais dans son apprentissage algorithmique plus de 1,6 mille milliards de paramètres.

Thèse professionnelle

Assiste-t-on à la course à l’échalote ?

Selon Aurélie Jean (Dr. Computational Scientist), la valeur des calculs d’apprentissages algorithmiques ne se mesure pas toujours au nombre de paramètres du système à résoudre, et à leurs tailles. En effet, elle s’évalue aussi à la pertinence de leurs réponses, leurs niveaux d’explicabilité ou encore leurs impacts économiques et humains : cf un algorithme de reconnaissance d’objets sur images, utilisant deux fois plus de paramètres avec un gain de 3 % seulement sur la précision du résultat.

Certes, mais toutes les entreprises n’ont pas les mêmes moyens que Google, ni les mêmes ambitions ou vocations en matière d’IA.

D’ailleurs certains projets ne nécessitent pas forcement d’entrainer des modèles. Parfois, il suffit d’ajuster un petit volume de paramètres en ayant des analyses statistiques et descriptives couplées à une bonne compréhension des besoins métiers.

En outre, certains projets, ne nécessitent pas forcement de gros volumes de données pour fonctionner. Car, l’entrainement des modèles complexes est plus souvent « réservé » à des solutions d’IA qui seront davantage déployées à grande l’échelle. Pour autant, dans ce cas de figure, il est possible, préférable même, d’utiliser des modèles open source qui ont déjà été entrainés. Et c’est notamment le cas pour la reconnaissance d’image où l’on recycle la technologie. Ici, on transfert les techniques d’apprentissage et on applique les données clients pour obtenir les résultats escomptés. Ceci, afin de limiter l’impact sur les ressources énergétiques nécessaires à un déploiement d’envergure.

L’ambition affichée de la part de nombreux ingénieurs et scientifiques est claire. Se rapprocher d’une IA qui consomme autant voire moins de 20w, tout en produisant des milliards d’opérations à la seconde. Autrement dit, l’équivalent de la consommation d’une intelligence humaine.

Comment développer une IA frugale selon Francis Basch (Directeur de recherche INRA)?

En outre, avant même de raisonner « projet », le choix de l’infrastructure informatique a des conséquences sur la consommation d’énergie. En effet, c’est le cas notamment lorsqu’on privilégie le Cloud au dépend des serveurs sur site. Selon le Natural Resources Defense Council (NRDC), un fournisseur de cloud à grande échelle atteint généralement des taux d’utilisation de serveur d’environ 65 % contre 15 % sur site. De plus, il utilise des installations écoénergétiques à grande échelle, des systèmes de refroidissement et des équipements optimisés pour la montée en charge de travail. Par ailleurs, très souvent, un fournisseur de cloud utilise un mix énergétique (composé d’énergie éolienne et solaire de grande envergure) moins friand en consommation carbone.

Enfin, pour aller plus loin sur la question de l’IA frugale, je vous invite à visionner le REPLAY de l’atelier 5 de l’événement Planet Tech’ Care (9 février 2021) : IA et consommation énergétique

L'intelligence artificielle main verte au secours de la planète

Les nouvelles technologies, telle que l’intelligence artificielle offrent de nombreuses perspectives contre la dégradation de l’environnement. Et elles n’agissent pas seules, bien entendu, ce sont des « mains vertes invisibles ». Elles aident l’homme dans ses perspectives de projets à fort impact positif. Ce sont des flux de données mis en place pour :

- collecter de l’information;

- interpréter des situations;

- et prendre des décisions préventives ou réparatrices, grâce à l’IA et ses précieux algorithmes.

Nous verrons dans ce chapitre de nombreuses initiatives de développement durable réparties selon les 4 éléments majeurs de notre planète : la terre, l’eau, l’air puis le feu.

L’IA main verte très terre-à-terre et pratique

Tout d’abord, notre habitat naturel est en perpétuel mouvement. Car au-delà de la rotation de la terre sur elle-même ainsi qu’autour du soleil, il y a la tectonique des plaques qui provoque :

- des tremblements de terre dans de nombreuses zones du globe ;

- des éruptions de volcaniques ou encore des tsunamis venant du fin fond des océans.

Chacun de ces phénomènes est une menace sérieuse pour l’homme et a déjà frappé des populations dans des zones habitées.

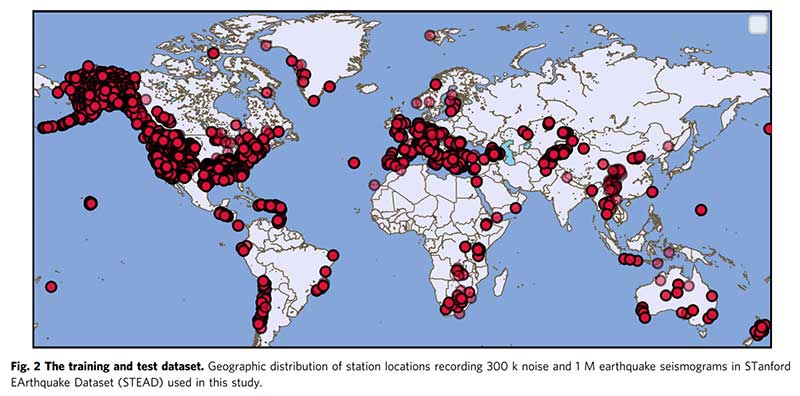

C’est pourquoi, des chercheurs de l’université de Stanford (États-Unis) ont développé une intelligence artificielle dotée d’un apprentissage profond. Et elle se nomme « Earth-quake Transformer« . Celle-ci permet de détecter des séismes grâce à l’identification de signaux si faibles qu’ils passaient jusque-là inaperçus auprès des capteurs répartis sur le globe. De plus, cette nouvelle approche, a permis de détecter et de localiser deux fois plus d’événements en utilisant moins d’un tiers des stations sismiques normalement nécessaires. Enfin, le modèle a été entrainé grâce à 5 semaines de données continues enregistrées lors des tremblements de terre de 2000 à Tottori au Japon.

En somme, la précision est proche de celle des analystes humains mais avec une bien plus grande rapidité. En plus, son efficacité et sa sensibilité lui permettent de caractériser des événements plus faibles, qui pourraient être les prémices de séismes majeurs.

Source : nature.com

Par ailleurs, sur des zones plus petites, les risques naturels gravitaires sont nombreux. Il s’agit des glissements de terrain, des torrents de boues, des éboulements rocheux ou les avalanches. Et ce sont des phénomènes complexes, difficiles à anticiper et à prévenir.

Dès lors, ces zones à risques disposent de plus de plus de nouveaux capteurs peu couteux, résistants dans le temps et peu consommateur d’énergie. Em somme, ils permettent de mesurer de nombreuses variations telles que :

- les longueurs (l’extensométrie);

- les angles (l’inclinométrie);

- les pressions d’eau (la piézométrie);

- les déplacements locaux (par le global positionning system ou GPS) ou globaux (par photogrammétrie).

En outre, il est possible aussi d’utiliser des techniques de scanner laser en surface (par le light detection and ranging ou LIDAR) ou de radar (par l’interferometric synthetic aperture radar ou InSAR).

Alors, une fois posés in-situ, ils collectent et partagent de nombreuses données. Et ils alimentent un algorithme d’apprentissage automatique, « un clone numérique ». Ce dernier est capable de détecter les points critiques, voire de recommander les mesures de confortement sur le terrain en question.

Enfin, Chaopeng Shen, professeur agrégé de génie civil et environnemental à Penn State (Etats-Unis), a développé le projet « deepLDB » grâce au financement de Google.

Il déclare que « Les glissements de terrain induits par les pluies représentent un risque énorme pour les personnes qui vivent dans les zones montagneuses, et nous avons pensé qu’il était possible d’utiliser l’IA pour mieux les prévoir. » En outre, ils provoquent de nombreuses victimes et coûtent des milliards de dollars, selon le United States Geological Survey (USGS).

Alors, en utilisant les images satellites de Google Earth (qui confèrent une très grande précision spatiale), les glissements de terrain passés peuvent être identifiés. C’est le rôle de l’intelligence artificielle dotée d’un apprentissage profond. Car une fois cette dernière entraînée à bien les reconnaitre, la zone de recherche est agrandie. Après un an d’entrainement, le modèle est capable d’identifier un glissement de terrain 97% du temps. Désormais, le travail des chercheurs consiste à prédire les futurs risques. Ils s’appuient sur les prévisions météos et autres conditions locales (telles que la texture et l’élévation du sol). La technologie n’est pas une fin en soi, mais bien un moyen d’améliorer les prédictions avec la précision la plus fine et un coût de plus en plus bas.

Enfin, nous exploitons les sols de façon exacerbée pour ses richesses naturelles, pour construire des habitations ou des infrastructures, et pour l’agriculture. Et, ils fournissent des services écosystémiques qui permettent la vie sur terre.

Selon vous d’où provient notre nourriture ?

95% de notre nourriture provient de nos sols. Nos sols ne sont pas une ressource renouvelable ! Du moins, il faut 1000 ans pour générer naturellement 1 cm carré.

Source : Selon l’Organisation des Nations Unies pour l'alimentation et l'agriculture Tweet

De fait, les sols subissent l’influence de nombreux facteurs. En effet, il y a notamment le matériau parental, le climat, son emplacement, les produits chimiques et les substances présentes dans l’eau. Mais encore l’interaction entre les hommes et les animaux. Or, la croissance mondiale de la population devrait entraîner une augmentation de 60% de la demande de denrées d’ici 2050.

Ce qui dès lors risque de dégrader encore plus nos terres et fragiliser la sécurité alimentaire si des mesures préventives et durables ne sont pas prises.

Source : Nos sols sont menacés (25/08/2015)

Ainsi, la société Trace Genomics a choisi de relever le défi d’augmenter durablement la production alimentaire tout en offrant de la valeur aux agriculteurs. En fait, elle s’appuie sur l’intelligence artificielle et la génomique microbienne.

Le principe est d’améliorer la gestion des sols en prélevant un échantillon à cultiver, de diagnostiquer sa santé et de proposer des recommandations aux agriculteurs :

- Tout d’abord, ils numérisent le sol vivant. Ils analysent la biologie du sol en appliquant une extraction et un séquençage d’ADN pour y indexer et quantifier des millions de microbes présents.

- Ensuite, ils décodent les données de ce sol. En exploitant l’apprentissage automatique, ils effectuent des analyses de données à haute vitesse et rentables pour les comparer à un ensemble important et croissant de données sur le sol.

- Enfin, ils combinent ces données biologiques du sol avec vos données chimiques et des informations de surface adaptées pour aider à la prise de décision. Les experts en sciences du sol proposent des recommandations fondées sur des données tangibles pour décider de la meilleure action à entreprendre dans les champs des producteurs.

L’intelligence artificielle nage en eaux troubles

L’eau est également un élément essentiel à la vie sur terre et nous en sommes nous-même constitué entre 55% (les femmes) et 60% (les hommes).

Quid de l’accès à l’eau salubre dans le monde ?

1 personne sur 3 dans le monde n’a pas accès à de l’eau salubre. Et plus de la moitié de la population mondiale ne dispose pas de services d’assainissement sûrs.

Source : Selon l’UNICEF ET L’OMS*, 18 juin 2019 Tweet

Loïc Fauchon, Président du Conseil Mondial de l’Eau, nous rappelle dans son webinar du 1 février 2021 que le futur de l’eau dispose à la fois des risques et menaces que d’opportunités.

L’eau et l’air même combat sécuritaire !

« L’eau, avec l’air, est la première ressource dont il faut assurer la Sécurité. Nos vies dépendent de la disponibilité de l'eau, en termes de quantité et en termes de qualité. »

Source : Loïc Fauchon, Président du Conseil Mondial de l’Eau Tweet

Les menaces qui pèsent sur l’eau

Malheureusement, elles sont nombreuses :

- pollutions (rejets domestiques, agricoles ou industriels);

- gaspillage (manque de structures d’assainissement des eaux ou de raccordement aux réseaux);

- rareté (Le détournement des cours d’eau pour les besoins de l’activité humaine),;

- causes de tensions à l’échelle mondiale…

Et selon des chercheurs du Groupement de recherche (GDR) « Polymères et Océans », « Il n’est plus possible de nettoyer les océans » des plastiques qu’ils contiennent. Car les quantités sont trop grandes et les coûts s’avèrent déjà trop élevés. De plus, ces chercheurs ont estimé le 10 février 2021, qu’environ dix millions de tonnes de plastiques finissent chaque année en mer et s’installent progressivement tout au fond.

En outre, le 31 janvier 2021, au lendemain du passage de la tempête Justine, le photographe météorologiste amateur, Florian Clément partage des photos de la Dune du Pyla. Et celle-ci est souillée par les déchets qui se sont échoués aux pieds de cette dernière. On distingue parfaitement les débris plastiques colorés qui sont présents partout.

Enfin en 2021, un premier procès du genre démarre, pour pollution plastique en mer Méditerranée. Et celui-ci donne suite à des déversements de millions de filtres par une station d’épuration en février 2018. Partiellement ramassés seulement, il en reste encore sur certaines plages de Campanie et se sont éparpillés jusqu’en Tunisie et en France.

Enfin, de nombreuses espèces animales sont piégés par ces plastiques, ils cohabitent avec, voire les ingurgitent et périssent.

L’intelligence artificielle source d’opportunités pour la qualité de l’eau

Les cours d’eau responsables des pollutions des mers !

Environ 1000 cours d’eau sont responsables de 80% des pollutions plastiques des océans.

Source : The Ocean Cleanup Tweet

Les plastiques ne sont pas les seuls responsables des pollutions de l’eau. Cependant, j’ai choisi de « matcher » un problème majeur et récurant avec des solutions nouvelles basées sur l’intelligence artificielle.

En l’occurrence, des opérations de nettoyage sont initiés à travers plusieurs initiatives et cette liste n’est bien entendu pas exhaustive. Et, en espérant qu’il ne soit pas trop tard et que nous sachions aussi réduire progressivement ces pollutions en amont.

Une équipe de scientifiques du Plymouth Marine Laboratory au Royaume-Uni a développé une intelligence artificielle dotée d’apprentissage profond. Celle-ci repère la pollution plastique en mer, en analysant des images de satellites Sentinel-2 de l’Agence spatiale européenne en orbite autour de la terre. En effet, les signatures spectrales de ces débris flottants dans l’eau fournissent les indices nécessaires à leur identification. Dès lors, l’algorithme qui a été utilisé en Écosse, au Ghana, au Vietnam ou encore au Canada, parvient à différencier les plastiques des autres matières dans 86% des cas. Désormais, ces mêmes scientifiques remontent les courants et étudient à présent les eaux fluviales et côtières.

Une autre initiative, toujours en surface, baptisée The Plastic Tide Project, emploie des drones appelés Marine Litter DRONET. Ils sont chargés de survoler certaines zones pour repérer les déchets plastiques grâce à l’intelligence artificielle dotée d’un apprentissage profond. Dès lors, les membres du collectif partagent les images et vidéos capturées. Ensuite, ils échangent des idées sur les mesures à prendre et établissent une vue d’ensemble avec des données standardisées. Enfin, ces données sont mises à disposition des scientifiques, des décideurs politiques, des entreprises et du grand public.

Par ailleurs, de leurs côtés, des chercheurs du MIT ont mis en place la solution Soft Robotic. Il s’agit d’un poisson robot prochainement dotée d’une intelligence artificielle et d’un apprentissage profond. Les scientifiques pourrons observer les créatures marines dans leur écosystème naturel, et surtout sans les effrayer. Ainsi, ils peuvent mesurer au fond des mers, l’impact de ces pollutions sur leurs comportements et sur leur environnement.

IA comme une menace dans l’air

L’air que nous respirons est chargé de gaz et de particules qui sont émis par les phénomènes naturels (éruptions volcaniques, brumes de sable, incendies de forêts, etc.). Et surtout les activités humaines (industries, transports, agriculture, chauffage résidentiel, etc.).

Les principales incidences de la pollution atmosphérique sont sur :

- La santé humaine

- L’environnement

- L’économie

La pollution de l’air meurtrière

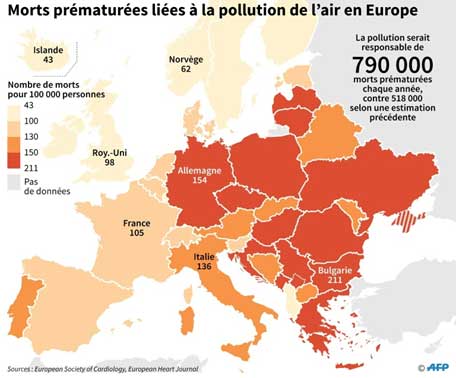

La pollution de l'air pourrait être responsable de près de 800.000 morts par an en Europe et 8,8 millions dans le monde.

Source : Morts prématurées liées à la pollution de l'air en Europe (AFP - Jonathan WALTER) Tweet

Source : scienceetavenir.fr

La qualité de l’air dans le monde

En 2016, 91% de la population mondiale vivaient dans des endroits où les lignes directrices de l’OMS relatives à la qualité de l’air n’étaient pas respectées.

Source : Organisation Mondiale de la Santé – 2 mai 2018 Tweet

En outre, les maladies pulmonaires ne sont pas les seules concernées par ce phénomène. Par exemple, la pollution de l’air pourrait également entrainer la perte irréversible de la vision, selon une étude révélée le 25 janvier 2021 par le British Journal of Ophthalmology.

En effet, les personnes les plus exposées à des zones polluées aux particules fines dans l’air, ont des taux les plus élevés de dégénérescence maculaire. Une autre observation faite cette fois liée auprès des personnes exposées au dioxyde d’azote, celui-ci entraine un changement d’épaisseur de la rétine.

Comment dépolluer l’air grâce à l’intelligence artificielle ?

De nombreuses mesures préventives sont déjà en place à tous les niveaux, que ce soit à titre individuel, dans les entreprises, les associations et les états…

Mais ce n’est évidemment pas suffisant ! Elon Musk, serial-innovateur est homme tantôt le plus riche du monde tantôt son second. Il vient d’annoncer un prix de 100 millions de dollars visant à financer les meilleures solutions de capture de CO2. Alors, si vous pouvez exhiber des prototypes pouvant être développés à grande échelle dans cette perspective, alors vous remportez la mise !

En attendant, de nombreuses solutions dotées d’intelligence artificielle voient le jour pour accélérer cette dépollution.

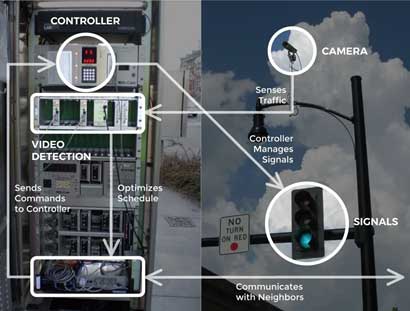

C’est le cas notamment avec solution Surtrac de Rapid Flow. Car elle apporte une amélioration significative de la synchronisation des feux de signalisation conventionnelle et autres systèmes adaptatifs.

En fait, ll s’agit d’un système de contrôle intelligent des feux de circulation en temps réel basé sur des techniques issues de la robotique et de l’intelligence artificielle. Le tout installé dans la ville de Pittsburgh aux États-Unis.

Dès lors, Surtrac détecte tout ce qui se passe en temps réel à l’intersection grâce à ses caméras, des radars ou même des boucles d’induction. Puis, son algorithme de planification crée un plan d’optimisation pour savoir comment déplacer le trafic multimodal à travers l’intersection. Ensuite, le système opère les commandes auprès du contrôleur pour coordonner les signaux en support de son plan d’optimisation.

Source : www.rapidflowtech.com

Surtrac coordonne les flux de trafic sur des réseaux complexes. Mais pas seulement sur des artères ou des corridors avec des schémas de trafic beaucoup moins dynamiques. Car, il est capable d’optimiser de nombreux modes de déplacement, en plus des véhicules, les cyclistes, les piétons et les transports en commun.

Les résultats sont concluants puisque :

- les temps de trajet ont été réduits de 25%;

- le temps d’attente aux signaux de 40;

- les arrêts de 30% et les émissions de 20%.

Dès lors, cette fluidification de trafic ou réduction d’embouteillage est synonyme de réduction de pollution urbaine.

Par ailleurs, de son côté, la société Octopus Lab dope la conception et la maintenance prédictive des bâtiments. Et son objectif est de fournir la meilleure approche possible en matière de ventilation et de qualité de l’air intérieur (QAI). Le tout grâce notamment à l’intelligence artificielle. Dans le contexte récent de Covid-19, l’air que nous respirons dans l’entreprise revêt un caractère encore plus critique lorsque nous sommes menacés par cette pandémie.

D’une part, lors de la conception ou la rénovation d’un bâtiment, la solution « Indalo » aide les bureaux d’études dans leurs choix de matériaux pour une ventilation optimisée. Car, elle exploite une vaste base de données qui dispose d’informations sur un millier de polluants ainsi que les informations relatives aux émissions des matériaux dans l’air intérieur.

D’autre part, en phase de maintenance, la solution « Indalo Supervision » évalue la qualité de l’air grâce à ses capteurs installés dans le bâtiment et les prévisions météorologiques. Car elle est équipée de Machine Learning qui analyse toutes ses données et estime la QAI à venir. De plus, elle paramètre la ventilation en fonction de l’occupation des locaux, des particules fines venues de l’extérieur et des pics de pollutions.

L’air source d’énergie renouvelable sans carbone

Alors, en dehors de l’aspect pollué de l’air, celui-ci sous la forme du vent constitue une formidable source d’énergie renouvelable sans carbone. Et celui-ci est encore sous exploitée à l’heure actuelle. En fait, cette énergie verte s’installe progressivement mais n’a pas encore atteint tout son potentiel. En effet, au cours de la dernière décennie, les parcs éoliens sont devenus une source importante d’électricité sans carbone. D’ailleurs, le coût des turbines a chuté à mesure que l’adoption a augmenté. Cependant, la nature variable du vent lui-même en fait une source d’énergie imprévisible. Et du coup moins utile que celle qui peut fournir de l’énergie de manière constante.

Alors, Google et sa filiale DeepMind AI ont combiné des données météorologiques avec leurs propres données issues de leurs parcs éoliens afin de mieux prévoir le vent.

En effet, à l’aide d’un réseau neuronal entrainé sur ces données ils peuvent désormais prédire la production d’énergie éolienne 36 heures avant la production réelle. Sur la base de ces prévisions, leur modèle recommande comment prendre des engagements de livraison horaires optimaux au réseau électrique une journée entière à l’avance. C’est important, car les sources d’énergie qui peuvent être programmées sont souvent plus précieuses pour le réseau. En d’autres termes, il s’agit de fournir une quantité déterminée d’électricité à un moment donné.

En fait, il n’est pas possible d’éliminer la variabilité du vent, mais les premiers résultats suggèrent que nous pouvons utiliser l’apprentissage automatique pour rendre l’énergie éolienne suffisamment prévisible et précieuse. Cette approche contribue également à apporter une plus grande rigueur des données aux opérations des parcs éoliens. En effet, l’apprentissage automatique peut vraiment aider les exploitants. Ils effectuent désormais des évaluations plus intelligentes, plus rapides et davantage basées sur les données de la façon dont leur production d’énergie peut répondre à la demande d’électricité.

Mais à ce jour, l’apprentissage automatique, a augmenté la valeur de l’énergie éolienne d’environ 20%, par rapport au scénario de base avec absence d’engagements temporels envers le réseau.

En somme, l’apprentissage automatique permet renforcer l’analyse de rentabilisation de l’énergie éolienne et favoriser l’adoption d’une énergie sans carbone sur les réseaux électriques du monde entier.

Source : https://deepmind.com/

L’IA main verte entre deux feux : la prévention et la réaction

En fait, en 2020, de nombreuses régions du monde ont connu d’intenses et dévastateurs feux de forêts, on parle de méga-feux, presque impossibles à éteindre : à l’ouest des États-Unis, en Arctique, en Australie, en Afrique centrale, en Indonésie ou encore au cœur des poumons de la planète en Amazonie.

Dès lors, le site notre-planete.info fourni des cartes actualisées des feux de forêt et panaches de fumée du monde dans les dernières 24 heures sur Terre. Ils sont détectés grâce aux images satellites météorologiques Suomi NPP et NOAA-201.

Alors, il peut s’agir de catastrophes naturelles liées notamment au réchauffement climatique qui aggrave mécaniquement le risque. Il peut s’agir aussi, des catastrophes industrielles, comme au Liban en août 2020. Mais encore de la déforestation continue comme en Amazonie.

Mais dans tous les cas, elles occasionnent de nombreux dégâts matériels. Ils menacent également les espèces vivantes et leurs habitats. De plus ils émettent d’énormes panaches de fumée qui polluent l’air et bloquent les rayons du soleil. Ils sont un enjeu sécuritaire et écologique majeur !

Le saviez-vous sur les fronts de déforestation ?

Il existe 24 « fronts de déforestation » dans le monde. Entre 2004 et 2017 la superficie équivalente au Maroc a disparu. 20% des forêts tropicales sont menacées.

Source : Les fronts de déforestation – WWF 2020 Tweet

Comment l’intelligence artificielle peut-elle épauler les soldats du feu ?

Celle-ci a la capacité d’analyser dans des laps de temps très courts, de grands volumes de données sur ces catastrophes :

- D’une part, sur l’influence de la météo (puissance du vent, montée des températures ou arrivée de la pluie);

- D’autre part, sur le milieu naturel en question (densité de végétation).

Le tout lui permet d’élaborer des modèles prédictifs pour mieux anticiper les situations à risques.

Mieux vaut prévenir que guérir!

C’est notamment l’objectif de que s’est fixée une équipe de chercheurs de l’Université de Californie, à San Diego. Leur logiciel doté d’intelligence artificielle classe la force de l’incendie en trois catégories : faible, moyenne ou importante. Ils l’ont mis en place au Nouveau-Mexique et affiche un taux de réussite relativement faible, de l’ordre de 50,4%. Selon eux, il faut fournir aux algorithmes davantage de données historiques pour obtenir de meilleurs résultats. De plus, il est recommandé de confirmer ou infirmer chaque prédiction (output) afin que le modèle l’intègre et affine son approche pour la suite.

L’Université de l’Alberta en collaboration avec l’Université de l’Oklahoma adoptent une approche similaire. Après trois ans de recherche, les scientifiques ont publié leur étude dans le « Canadian Journal of Forest Research ».

Lorsque la prévention ne suffit pas, il faut agir vite!

La socitété Descartes Labs est une start-up d’analyse d’images géospatiales de Santa Fe, au Nouveau-Mexique. Elle a mise au point une intelligence artificielle capable de localiser l’emplacement d’un incendie en seulement neuf minutes après son départ.

Pour cela, son logiciel doté de deep learning examine toutes les deux minutes les images de deux satellites météorologiques. Elles appartiennent à l’agence américaine d’observation océanique et atmosphérique (NOAA), GOES-16 et GOES-17. Il repère ainsi la présence de fumée, un changement de température anormal et donne l’alerte dans les minutes qui suivent.

En outre, cette rapidité de l’information et la précision que procure la solution permet aux gestionnaires des incendies plus d’options sur le plan d’action. Plus le temps passe, plus il est difficile de contenir et de stopper l’incendie.

Infographie : cliquez sur l'image pour l'agrandir

Expert du Digital avec plus de 20 ans d’expérience au service du B2B et du B2C, dans toutes les tailles d’entreprise et à l’échelle internationale. Mes plus récents développements ont été orientées vers des solutions e-commerce et Omnicanales. Passionné, je suis auteur, formateur et en veille permanente.

Contrôler et améliorer l’expérience client grâce à l’intelligence artificielle

Découvrez mon « Capstone Project » issu de ma formation pour cadre de l’Université Berkeley ExecEd de Californie :

« Artificial Intelligence: Business Strategies and Applications »