Le produit digital et l'expérience de recherche augmentés par l’IA

J’ai cherché et trouvé en moins d’une minute ! Depuis juillet 2021, nous sommes 5,17 milliards d’internautes (soit 65 % de la population, c’est 10% de plus depuis janvier 2021) qui utilisent Internet dans la vie quotidienne. Et dans ce réseau des réseaux, en 1 minute, il s’en passe des choses. A en croire Domo qui vient justement de publier sa désormais célèbre infographie annuelle : sur Google, le moteur de recherche numéro 1 mondial, ce ne sont pas moins de 5,7 millions de recherches réalisées en 60 secondes chrono. C’est vertigineux et en croissance continue… et pour cause : Nous avons tous développé le réflexe Google pour obtenir tout et tout de suite évidemment. Cet apprentissage a démarré auparavant sur desktop, ensuite sur mobile, puis sous de multiples autres form-factor.

Toutes ces évolutions et les nouveaux comportements qui les accompagnent ne sont pas sans effets kiss cool pour nos marketeurs et leurs assets digitaux. Pour aborder ce sujet business critical, j’ai le plaisir de m’entretenir avec Franck Negro, Managing Director Southern of Europe chez Yext. Vous allez découvrir pourquoi c’est si important et comment considérer le contexte de recherche de nos prospects et clients. Et surtout, comment s’armer d’une value proposition, basée notamment sur l’intelligence artificielle, à la hauteur de leurs attentes pour mieux satisfaire leurs quêtes et les fidéliser durablement.

Biographie de Franck Negro

Titulaire d’un DEA de philosophie (Université de Paris X Nanterre) et d’un Master 2 en Management (Université de Paris-Dauphine), Franck Negro débute sa carrière comme Ingénieur Commercial chez Canon France, puis Xerox France.

En 1997, il rejoint la société Adobe Systems France, où il occupe successivement les postes d’Ingénieur Commercial grands-comptes puis partenaires, Sr. Channel Manager France, Sales Director Channel France et Italie, Sales Director Channel SouthWest of Europe, et enfin, Sales Director SMB SouthWest of Europe.

De 2012 à 2014, il négocie avec succès la transformation du business model d’Adobe de la vente de licences perpétuelles à la vente de licences logicielles sous la forme d’abonnement. En février 2015, Franck Negro rejoint Experian Marketing France où il prend les fonctions de Chief Operating Officer, puis de Managing Director à partir d’Octobre 2015.

Il occupe le poste de Managing Director Southern of Europe chez Yext (côté au NYSE) depuis février 2017.

Comment Yext se positionne-t-il vis-à-vis des moteurs de recherche référents tels que Google, Yandex ou Baidu ?

Il y a une façon simple et une façon un peu plus développée de répondre à la question. De façon simplifiée, les personnes peuvent rechercher de l’information soit dans Google, Bing, Yandex ou Baidu, soit sur un site web de marque. Le site de Samsung, de La Poste ou de SFR par exemple. La vocation de Yext n’est naturellement pas de venir concurrencer Google ou Bing. Mais de permettre aux marques et organisations du monde entier de proposer à leurs clients et prospects des parcours de recherche exceptionnels partout où ils sont susceptibles de rechercher de l’information. Et ce, que ce soit dans des applications tierces de types Google Search (moteur de recherche) ou Google Maps (système de cartographie), ou encore, sur le propre site web d’une organisation donnée.

La plateforme Yext va ainsi opérer à la fois comme une source de données unique permettant aux marques d’être visibles sur la grande majorité des applications tierces du marché : moteurs de recherche, systèmes de cartographie, réseaux sociaux, assistants vocaux, annuaires locaux...

Mais aussi d’être en capacité de proposer sur leur(s) propre(s) site(s) web une expérience de recherche au moins aussi bonne que celle proposée aujourd’hui par Google. Ce dernier est à ce jour, le moteur de référence, avec plus de 92% de part de marché au niveau mondial.

L’innovation chez YEXT

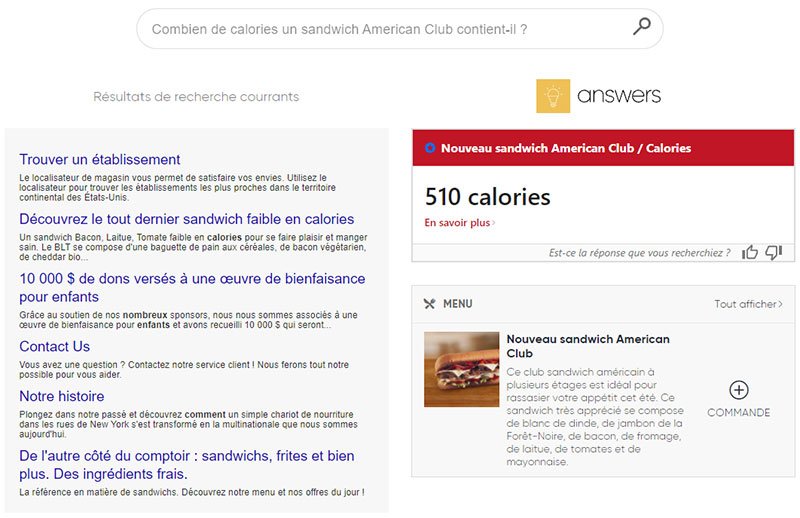

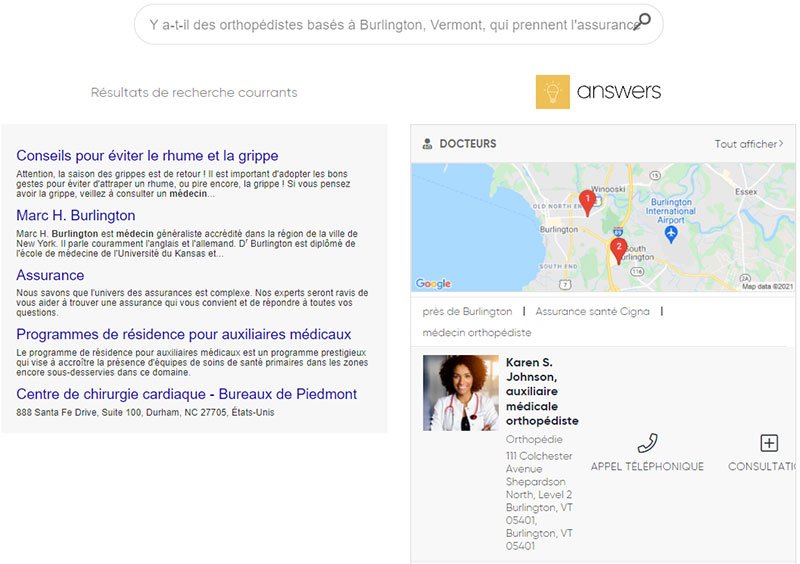

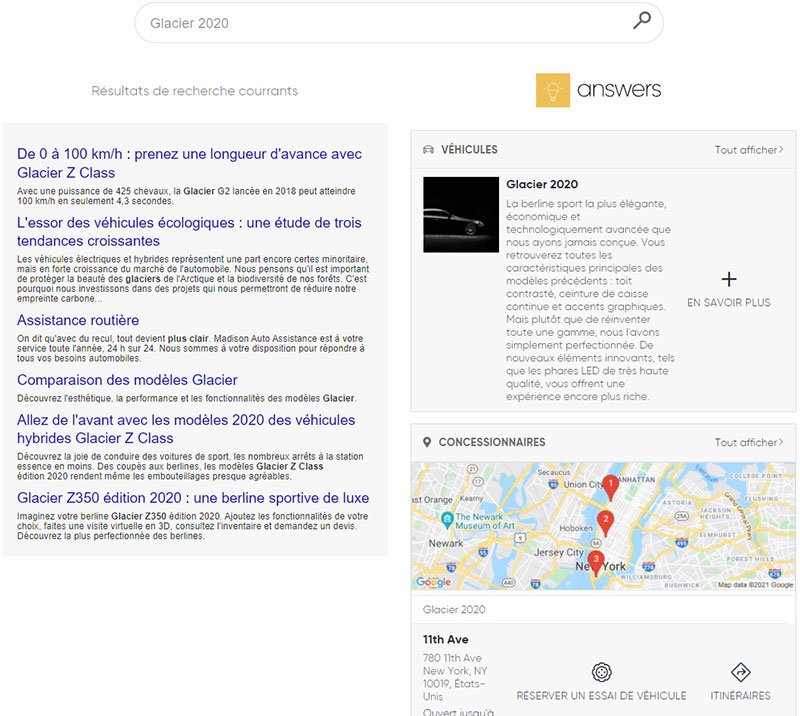

Pour ce faire, nous avons étendu les fonctionnalités de la plateforme Yext en développant un moteur de recherche pour les sites web des organisations (Yext Answers). Il tire pleinement parti des deux plus grandes avancées en matière de Search sur ces dix dernières années. C’est à dire :

- le traitement automatique du langage naturel (Natural Langage Processing ou NLP en anglais) pour la compréhension sémantique des requêtes formulée de plus en plus sous la forme de questions ;

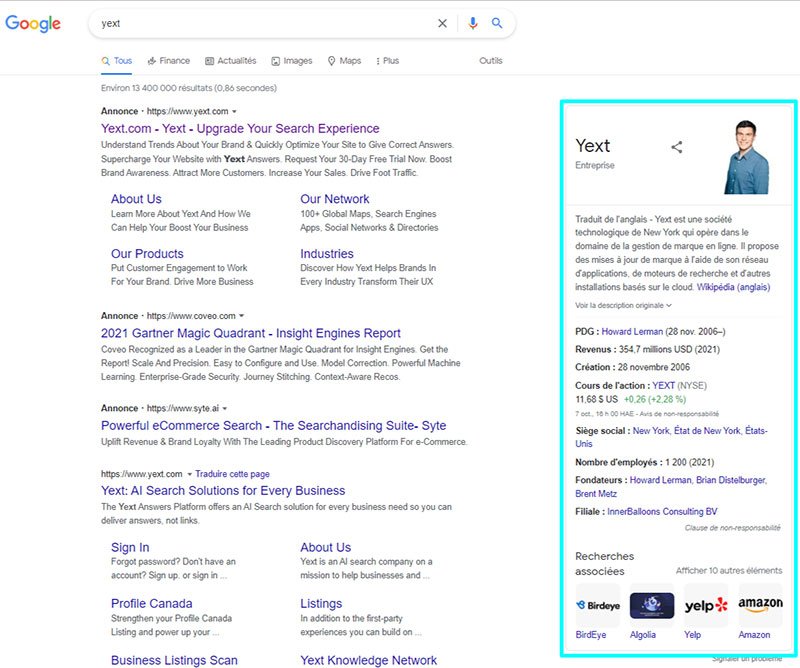

- et les Knowledge Graph ou graphes de connaissances. Popularisé par Google dès 2012, les graphes de connaissances sont des modèles de stockage et de représentations des connaissances très intuitifs qui facilitent le travail de compréhension et de navigation des moteurs de recherche dans de grands volumes de données structurées. Et il permet ainsi la réponse directe à des questions (plutôt que des liens bleus à cliquer), notamment lorsque celles-ci portent sur ce que l’on appelle des entités nommées, comme un produit, une personne, une organisation, ou un lieu physique. Je reviendrai sur ces notions importantes un peu plus loin.

Exemple de knowledge graph Google

Pourquoi une expérience de recherche est-elle si importante pour les clients ou prospects d’une marque ?

Lorsque l’on me pose cette question, j’aime assez à rappeler un article qui a été publié dans la Harvard Business Review de novembre-décembre 2019. Il a été écrit par deux éminents professeurs du MIT. Il y est question de la valeur contributive de la révolution digitale au PIB, étant donné que la grande majorité des services digitaux que nous utilisons sont gratuits. Ils ne sont donc pas pris (ou mal pris) en compte dans les statistiques officielles.

Les auteurs font appel à une mesure – connues des économistes – que l’on appelle le surplus du consommateur, que l’on peut évaluer entre autres en demandant aux personnes : « Combien d'argent faudrait-il vous donner pour que vous renonciez pendant un an à l’accès à des services digitaux tels que Google, Facebook, ou YouTube par exemple ? » Les résultats sont édifiants.

Que montre en effet l’étude ? Que l’usage des moteurs de recherche vaut littéralement plus que les cinq autres grandes catégories de services digitaux réunies. Soit les réseaux sociaux, les plateformes de partage de vidéos en ligne, les services de cartographie, l’e-commerce, et l’e-mailing. Elle montre surtout clairement combien la recherche d’informations est incroyablement importante dans la vie quotidienne des personnes.

Est-il besoin de rappeler que 90% des consommateurs indiquent avoir recours à un moteur de recherche à chacune des étapes de leur parcours client. Tandis qu’en moyenne, plus de 60% du trafic d’un site web est généré par les moteurs de recherche.

L’Expérience de recherche est un MUST

Il faut donc prendre très au sérieux l’expérience de recherche que vous êtes en mesure de fournir à vos clients. Lorsqu’ils se trouvent sur Google bien sûr. Mais aussi lorsqu’ils se trouvent sur votre propre site web. Et c’est principalement sur ce dernier point que le bât blesse aujourd’hui.

Il y a en effet un fossé abyssal entre la qualité de l’expérience de recherche que vous obtenez sur un moteur de type Google, lequel s’est constamment amélioré pendant 25 ans. Et l’expérience de recherche que vous avez sur la grande majorité des sites web de marques. Je m’explique.

La façon dont nous interagissons avec les technologies changent en permanence à travers le temps, et modifie nos comportements de recherche. Nous connaissons tous les interfaces graphiques depuis la révolution de l’ordinateur personnel (PC) au début des années 1980, ou encore les écrans tactiles depuis le lancement du Smartphone en 2007.

Nous sommes au milieu d’un autre grand changement provoqué, comme je l’ai rappelé plus haut. Celui des progrès immenses qui ont été réalisés dans la compréhension des langues naturelles. Et ce grâce notamment aux recherches menées dans le domaine du traitement automatique des langues naturelle (NLP).

Les moteurs de recherche évoluent avec la sémantique

Grâce à ces progrès, nous effectuons de plus en plus de recherches sous la forme de phrase longues énoncées en langage naturel. Plus de 50% des requêtes sont constituées de quatre mots et plus. Plutôt que « Lexus », ils auront tendance à chercher : « Concessionnaire Lexus à Lyon avec options de financement », sans douter que les nouveaux algorithmes d’aujourd’hui, basés sur des modèles de Machine Learning, seront en capacité de comprendre leur requête complexe et de fournir des résultats pertinents.

Simplement dit, le traitement automatique du language naturel est en effet une sous-discipline de l’Intelligence Artificielle. Il est notamment utilisé dans des applications qui mettent en jeu la compréhension sémantique, syntaxique et contextuelle d’une requête énoncée sous la forme d’une question.

Dès lors, chaque fois que vous utilisez un moteur de recherche comme Google ou Bing, vous tirez parti des dernières avancées réalisées en matière d’IA et de NLP. Google – pour ne citer que le moteur le plus utilisé au monde -, est capable :

- non seulement de comprendre les intentions de recherche d’un internaute donné (un peu comme le ferait finalement un cerveau humain) ;

- et de ce fait, de fournir à cet internaute des réponses directes dans la page de résultats (SERP), sous la forme de featured snippet, de local pack ou de knowledge card.

Demander directement – la nouvelle norme utilisateur

Autrement dit, Google est littéralement en train de réhabituer les personnes à demander simplement ce qu’ils veulent en langage naturel, et d’avoir des réponses directes à leurs questions sans avoir à naviguer dans des dizaines de pages web. Et pour les millions d’internautes que nous sommes, Google constitue la norme en matière d’expérience de recherche sur le web.

Pourtant, lorsque nous nous rendons sur la majorité des sites web de marques, force est de constater que l’expérience de recherche proposée n’est pas à la hauteur de nos attentes. Nous souhaitons en effet simplement pouvoir poser des questions, comme nous le ferions sur Google. Le problème, est que nous ne pouvons pas le faire sur la plupart des sites web d’aujourd’hui. Alors que faisons-nous ? Que font les clients ou prospects des marques s’ils ne trouvent pas ce qu’ils sont venus chercher sur un site web ? Ils abandonnent et repartent d’où ils viennent, à savoir… Google.

Et lorsqu’ils retournent sur Google, ils peuvent non seulement trouver des informations erronées sur la marque en question, mais surtout rencontrer ses concurrents. 68% des personnes qui ont une expérience de recherche déceptive avec le moteur de recherche d’un site web ne reviennent plus.

Or le paradoxe est que les marques dépensent beaucoup d’argent pour faire venir des clients sur leur site web.

Quelles expériences de recherches exceptionnelles proposent Yext ?

Partons d’un certain nombre de constats évidents. Mettre en place une expérience de recherche exceptionnelle aujourd’hui implique de tenir compte de deux grands défis que tout responsable marketing devrait avoir à l’esprit.

Les défits du responsable marketing

Tout d’abord, le problème de la surcharge d’information. La quantité d’informations disponibles sur le web double tous les deux ans. Il devient paradoxalement plus difficile pour les consommateurs de prendre des décisions d’achat. Ce qui pousse en quelque sorte les consommateurs à poser des questions toujours plus complexes en augmentant notamment la longueur de leurs requêtes. Et ce phénomène n’est pas prêt de s’arrêter.

Ensuite, l’incroyable complexité et diversité des parcours clients. Ce que montre une étude récente de Google de façon extrêmement bien documentée et que l’on peut trouver facilement sur le web : Decoding Decision. Making sense of the Messy Middle (.pdf 3,36 Mo). De façon très synthétique, l’étude montre

- qu’il n’y a pas deux parcours clients identiques ;

- que la forme de ces parcours n’est pas linéaire (le web est structuré de telle sorte que vous pouvez emprunter une infinité de chemins différents) ;

- que les ressources mises à disposition sont quasi illimitées et disponibles sur des dizaines de sources d’information différentes. C’est cette réalité complexe, située entre le moment où un besoin émerge et une décision d’achat est prise que Google appelle : le messy middle. Que l’on peut traduire par « milieu désordonnée ».

The messy middle by Google

Toutes les actions effectuées dans cette espace nous dit Google, oscillent entre deux grandes catégories de recherches :

- des recherches de type « exploratoires », pour obtenir des informations sur un produit ou un service par exemple ;

- et des recherches de type « évaluatives » qui visent, comme son nom l’indique, à évaluer l’ensemble des possibilités découvertes pendant la phase d’exploration.

Et Google de conclure par une phrase qui pourrait servir de fondement à la mise en place d’une stratégie de Search :

« L'objectif n'est pas de forcer les gens à sortir de la boucle représentée dans le modèle, mais de fournir à vos consommateurs les informations et les éléments de réassurance dont ils ont besoin pour prendre leur décision »

Google himslef Tweet

La réponse de Yext aux entreprises relève du bon sens

Répondez de façon la plus exhaustive possible à toutes les questions de vos consommateurs partout où ils sont susceptibles de les poser. Que ce soit sur des applications tierces (Google Search, Bing Search, Google Maps, Apple Maps, Facebook, Alexa, Siri…) ou le site web de la marque. Et en raccourcissant au maximum les boucles d’exploration-évaluation caractéristiques d’un parcours de recherche. Le but est d’éviter que vos clients potentiels soient exposés trop longtemps à des marques concurrentes.

La meilleure façon pour les marques de répondre à ces deux grands défis, est de faire comme Google, Facebook, Microsoft. Utiliser la simplicité, la flexibilité, l’intelligence et la puissance d’un Knowledge Graph, associées aux technologies de NLP (Natural Language Processing). Vous serez dès lors en capacité de répondre à toutes les questions posées par les consommateurs partout où ces derniers sont susceptibles de rechercher de l’information. Bref, d’optimiser tous les parcours de recherches à chacune des étapes du cycle d’achat client. Que ce soit dans une optique d’acquisition de trafic online et offline (drive-to-store), de conversion sur le site web de la marque (e-commerce). Ou encore de permettre à des personnes d’obtenir des réponses à des questions relatives au support client de l’entreprise en toute autonomie, sans avoir à solliciter un agent par e-mail, par chat ou par téléphone (service client).

Comment l’intelligence artificielle contribue à la création de valeur de vos solutions ?

Un tout petit peu de mise en perspective d’abord. La recherche au sens traditionnel du terme, telle qu’elle a été conçue au tout début du développement « grand public » du web (1994), reposait sur un modèle de recherche par mots-clés et un unique algorithme. Ces moteurs de recherche sont basés sur des indexes. Pour simplifier à l’extrême, ils parcourent toutes les pages du web, indexent chaque mot de la page, et lorsqu’une personne tape une requête, ils renvoient les documents qui contiennent les mots clés tapés dans la barre de recherche.

Pour la petite histoire, le principal algorithme de recherche par mots-clés s’appelle TF-IDF pour « Term Frequency Inverse Document Frequency. Il a été mis au point dans les années 1970, par une scientifique britanique qui travaillait dans le domaine du traitement automatique du langage naturel (NLP), à savoir, Karen Spärck-Jones.

TF-IDF dépend ainsi des mots clés de la requête, et de la fréquence d’utilisation de ces termes dans des pages web. En d’autres termes, le document qui contient le plus grand nombre de mots-clés apparaîtra en premier.

Le défaut principal des moteurs de recherche

fonctionnant sur la base de mots-clés est qu’ils sont, dans la vaste majorité des cas, incapables de répondre directement et de façon pertinente aux questions des internautes. En effet, ils se contentent de renvoyer des dizaines, voire des centaines de liens bleus qui pointent vers des pages qui contiennent les mots clés de la requête.

Ils ne recherchent pas des produits, des personnes, des évènements ou des points de vente, mais des mots dans des pages.

Rappelons d’ailleurs que Google a commencé par fonctionner sur le principe des mots-clés, en améliorant néanmoins la pertinence des résultats obtenus grâce à un indicateur de popularité qui est son fameux PageRank, et ce, dès 1998.

D’autres avancées notables sont apparues entre temps, comme le traitement des synonymes à partir de 2003, l’autocomplétion en 2005, ou encore la recherche universelle en 2007.

Mais des changements radicaux interviennent notamment depuis l’année charnière de 2012, avec le Knowledge Graph, qui sort la même année, le lancement des featured snippets en 2016 (extrait de texte web affiché en position 0 dans la page de résultat de Google), ou encore, l’annonce officiel de BERT (Bidirectional Encoder Representations from Transformers) en 2019, qui est un algorithme de machine learning dédié au traitement du langage naturel et la compréhension des requêtes longues de type « conversationnelles ».

Dotez votre moteur d'une nouvelle philosophie : le moteur de réponses

Toutes ces innovations attestent d’un changement profond de philosophie qui consiste à passer d’un moteur de recherche à un moteur de réponses, grâce notamment à l’association de l’Intelligence Artificielle (NLP) et du modèle de stockage et de représentation des connaissances le plus adapté à la recherche d’informations : les knowledge graph type Yext.

Le grand paradoxe est que si Google a sans cesse continué à faire évoluer la recherche d’informations dans le domaine grand public au cours des vingt dernières années, ce n’est malheureusement pas le cas des moteurs de recherche pour les sites web des entreprises. En d’autres termes, la recherche en entreprise est restée bloquée dans les années 2000.

Or pour qu’une entreprise puissent proposer sur son propre site web une expérience de recherche au moins similaire à Google, elle doit en quelque sorte reprendre les mêmes ingrédients à savoir :

- utiliser les avancés réalisées dans le domaine du NLP pour comprendre les questions et intentions de recherche des personnes qui arrivent sur le site web de la marque ;

- s’appuyer sur plusieurs types d’algorithmes de machine learning pour être en capacité de présenter le meilleur résultat possible en fonction de la nature des questions posées et des catégories de données stockées dans le knowledge graph (données structurées comme les informations produits ou points de vente, semi-structurées comme des pages FAQ, ou non structurées comme des articles de blogs ou de services client) ;

- être en capacité de fournir des résultats dans une interface utilisateur dynamique selon la nature des questions posées ;

- et enfin, être construit sur un Knowledge Graph.

Quels sont tes conseils en matière de contenus marketing pour les marques afin d’enrichir les réponses auprès des utilisateurs ?

Jusqu’à maintenant, nous avons principalement parler de l’Intelligence Artificielle pour comprendre et classer des contenus. Mais l’IA demain ce sera aussi créer des contenus. La quantité d’informations disponibles sur le web va continuer à croître de façon exponentielle. L’espace sémantique des marques, à savoir le nombre de questions sur lesquelles elles pourront potentiellement se positionner devrait littéralement exploser. Dans ce cadre, la qualité des réponses qu’elle sera en capacité de fournir, quelle que soit le point de contact digital utilisé par ces clients ou prospect devient un enjeu stratégique majeur.

De ce point de vue, l’histoire de l’adoption du knowledge par Google est très instructive. En 2009, Amit Synghal, à l’époque Senior Vice President de Google, cherche un moyen d’améliorer la qualité des résultats du moteur de recherche qui selon lui ne progresse pas assez. Il décide alors de regarder du côté de l’intelligence artificielle, et notamment d’une société qui s’appelle Metaweb Technology. Cette société possède une base de connaissances énorme sous la forme d’un knowledge graph qui s’appelle Freebase, et dont l’objectif est de fédérer toute la connaissance humaine et nourrir à terme une intelligence artificielle. Metaweb sera racheté en 2010 par Google, qui déploiera son propre knowledge graph deux années plus tard.

Le knowledge graph selon Google procède d’une idée simple à l’époque mais avant-gardiste : il existe et il existera à terme une quantité de données infinie. Le seul moyen pour un moteur de recherche d’en tirer parti est de les structurer. En d’autres termes, si le moteur de recherche de l’époque avait des limites, c’est parce que les données qu’il y avait dans son indexe n’étaient pas construite pour représenter de façon adéquate des connaissances et répondre de façon pertinente à des questions.

Le mimétisme de google

Nous disons donc aux entreprises : construisez votre propre knowledge graph pour y intégrer tous vos contenus. Ce dernier doit comprendre de façon la plus granulaire possible toutes les données publiques relatives à votre marque : vos produits, vos points de vente, vos services, vos évènements, des informations sur votre organisation, sur votre service après-vente…

Ce knowledge graph va principalement avoir trois fonctions :

- servir de base de connaissances unique alimentant tous les points de contact digitaux utilisés par vos clients dans le cadre d’un parcours de recherches d’informations, voire des parties prenantes internes à votre entreprise comme des agents de service client par exemple ;

- structurer sémantiquement vos contenus pour l’optimisation de votre stratégie SEO. Rappelez-vous que le fonctionnement des algorithmes de Google ou de Bing est de plus en plus basé sur des entités (produits, personnes, points de vente, services, organisations, évènements…) et des relations entre ses entités ;

- permettre de proposer sur son propre site web une expérience de recherche au moins similaire à ce qu’un internaute peut avoir sur Google.

illustrations de résultats de recherche avec et sans knowledge graph :

MustWatch : Pour un marketing digital responsable

Quels facteurs clés a permis à Yext de remporter un WMA Awards ?

What’s next chez Yext ?

L’expérience ultime via la recherche universelle

Yext sera d’ailleurs présent au Hub Forum le 12 et 13 octobre avec justement une masterclass portant sur les parcours de recherche online, depuis Google jusqu’au service client. Nous aborderons ses sujets à nouveau à l’occasion du One to One Monaco, lors d’un workshop le 26 octobre.

Expert du Digital avec plus de 20 ans d’expérience au service du B2B et du B2C, dans toutes les tailles d’entreprise et à l’échelle internationale. Mes plus récents développements ont été orientées vers des solutions e-commerce et Omnicanales. Passionné, je suis auteur, formateur et en veille permanente.

Contrôler et améliorer l’expérience client grâce à l’intelligence artificielle

Découvrez mon « Capstone Project » issu de ma formation pour cadre de l’Université Berkeley ExecEd de Californie :

« Artificial Intelligence: Business Strategies and Applications »

Un commentaire